Safer Internet Day 2026

Unter dem Motto „Together for a better Internet“ machen sich alljährlich im Februar zum Safer Internet Day viele Menschen und Institutionen auf der ganzen Welt dafür stark, die Sicherheit im Internet zu verbessern. Besonders Kinder und Jugendliche sollen im selbstbestimmten und verantwortungsvollen Umgang mit digitalen Medien unterstützt werden.

Ansatzpunkte gibt es dabei viele: der respektvolle Umgang miteinander, die Förderung der Medienkompetenz, die Schaffung adäquater rechtlicher Rahmenbedingungen oder auch die Bereitstellung hochwertiger Angebote für Kinder und Jugendliche.

Zum Safer Internet Day 2026 (SID26) am 10. Februar stellt die EU-Initiative klicksafe mit dem Thema „KI and me. In künstlicher Beziehung.“ die Frage in den Mittelpunkt, wie sich die zunehmende Nutzung von KI-Begleitern auf unser Miteinander und vor allem auf das Aufwachsen von Kindern und Jugendlichen auswirkt.

Das W-Seminar ‚Digitaler Fußabdruck‘ hat sich mit verschiedenen Aspekten rund um KI auseinandergesetzt. Nutzt die nachfolgenden Anregungen.

Künstliche Intelligenz ist längst ein fester Bestandteil des modernen Lebens. Besonders Chatbots übernehmen oft kommunikative Aufgaben und wirken wie verständnisvolle Gesprächspartner. Dadurch dass KI in natürlicher Sprache kommuniziert, schnell reagiert und personalisierte Antworten gibt, fühlt sich die Interaktion sehr menschlich an. Dieser Eindruck ist psychologisch bedeutsam, denn Menschen sind soziale Wesen und reagieren automatisch auf sprachliche und emotionale Signale.

Psychologische Wirkung von KI-Systemen

Ein zentrales Phänomen ist die sogenannte Anthropomorphisierung. Dabei schreiben Menschen technischen Systemen menschliche Eigenschaften wie Verständnis, Absichten oder Gefühle zu. Obwohl KI keine Emotionen besitzt, wird sie oft wie eine Person behandelt.

Jugendliche und KI

Jugendliche wachsen mit digitalen Technologien auf und nutzen KI besonders intensiv. Sie verwenden Chatbots zum Lernen, zur Ideensuche oder als digitale Gesprächspartner. Da sich soziale Kompetenzen in dieser Lebensphase noch entwickeln, können KI-Interaktionen reale soziale Erfahrungen teilweise ersetzen.

Kommunikation über KI unterscheidet sich jedoch stark von echter menschlicher Interaktion. Mimik, Körpersprache, Missverständnisse oder Konflikte gehören zum sozialen Leben dazu. Wenn diese Erfahrungen fehlen, können wichtige Fähigkeiten wie Empathie, Geduld oder Konfliktlösung geschwächt werden.

Zudem können Jugendliche Schwierigkeiten haben, KI-Inhalte kritisch zu bewerten. Ohne ausreichende Medienkompetenz ist es schwer zu erkennen, dass KI zwar überzeugend formuliert, aber nicht immer richtig liegt.

Chancen von KI

Neben Risiken bietet KI auch große Chancen. Sie kann den Lernprozess unterstützen, komplexe Inhalte vereinfachen und individuelle Hilfestellungen geben. In stressigen Situationen kann sie eine kurzfristige Entlastung sein. Entscheidend ist jedoch, dass KI als Werkzeug genutzt wird und nicht als Ersatz für menschliche Interaktion.

Risiken der KI-Nutzung

Durch wiederholte Nutzung kann eine parasoziale Beziehung entstehen. Eine einseitige emotionale Bindung, bei der die KI als verlässlicher Gesprächspartner wahrgenommen wird. Diese Beziehung kann kurzfristig entlastend wirken, etwa bei Stress oder Einsamkeit. Langfristig besteht jedoch das Risiko, dass echte soziale Kontakte weniger gepflegt werden.

In einem tragischen Fall in den USA nahm sich ein depressiver Teenager das Leben, nachdem er über lange Zeit intensive Gespräche mit einem KI-Chatbot geführt hatte. Dieser bestärkte die dunklen Fantasien des Jugendlichen und fragte ihn sogar, ob er schon einmal über Suizid nachgedacht habe.

Dieses Beispiel zeigt, dass einseitige emotionale Bindungen zur KI besonders bei Jugendlichen zu starker Abhängigkeit und sozialer Isolation führen können. Effekte, die psychisches Wohlbefinden gefährden, wenn sie reale soziale Kontakte ersetzen.

Ein weiteres Risiko ist der Automatisierungs-Bias. Menschen tendieren dazu, Vorschläge von der KI als besonders objektiv und korrekt zu betrachten. KI-generierte Inhalte wirken oft strukturiert und überzeugend. Dadurch werden Fehler nicht immer erkannt.

Wenn Informationen unkritisch übernommen werden, dann kann dies die eigene Meinungsbildung beeinflussen. Langfristig könnten kritisches Denken, Recherchefähigkeit und Problemlösekompetenz geschwächt werden. Das Gehirn gewöhnt sich daran, schnelle Antworten zu erhalten, anstatt selbst Lösungswege zu entwickeln. Die ständige Verfügbarkeit von KI erzeugt den Druck, immer sofort Lösungen finden zu müssen.

Unkritische Nutzung von KI kann Entscheidungsfähigkeit und Selbstständigkeit schwächen.

Fazit

Die psychologischen Auswirkungen von KI hängen stark von der Art der Nutzung ab. Ein bewusster Umgang ermöglicht es Vorteile zu nutzen und Risiken zu verringern. Wichtig bleibt, die Inhalte kritisch zu prüfen, eigene Meinungen zu bilden und reale soziale Kontakte aktiv zu pflegen.

KI ist ein hilfreiches Werkzeug aber kein Ersatz für echte Beziehungen oder eigenes Denken

Quellen

- https://www.aok-systems.de/news/blog/beitrag/grenzen-von-ki-die-psychologische-komponente.html

- https://www.scinexx.de/news/psychologie/warum-uns-ki-nachhaltig-beeinflusst/

- https://publikationen.dguv.de/widgets/pdf/download/article/5137

- https://www.klicksafe.de/pressemitteilungen/safer-internet-day-2026-ki-and-me-in-kuenstlicher-beziehung

- https://de.statista.com/infografik/35480/umfrage-zur-nutzung-von-ki-anwendungen-unter-12-bis-19-jaehrigen/

- https://www.br.de/nachrichten/netzwelt/wenn-ki-freunde-zur-gefahr-werden-suizid-in-den-usa-zeigt-tragischen-verlauf-einer-ki-beziehung,USgb6Ux

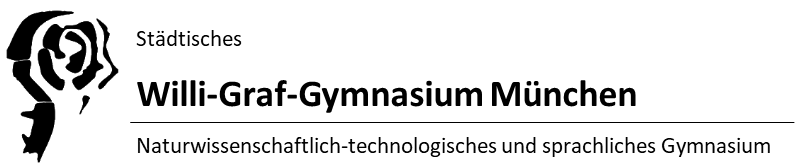

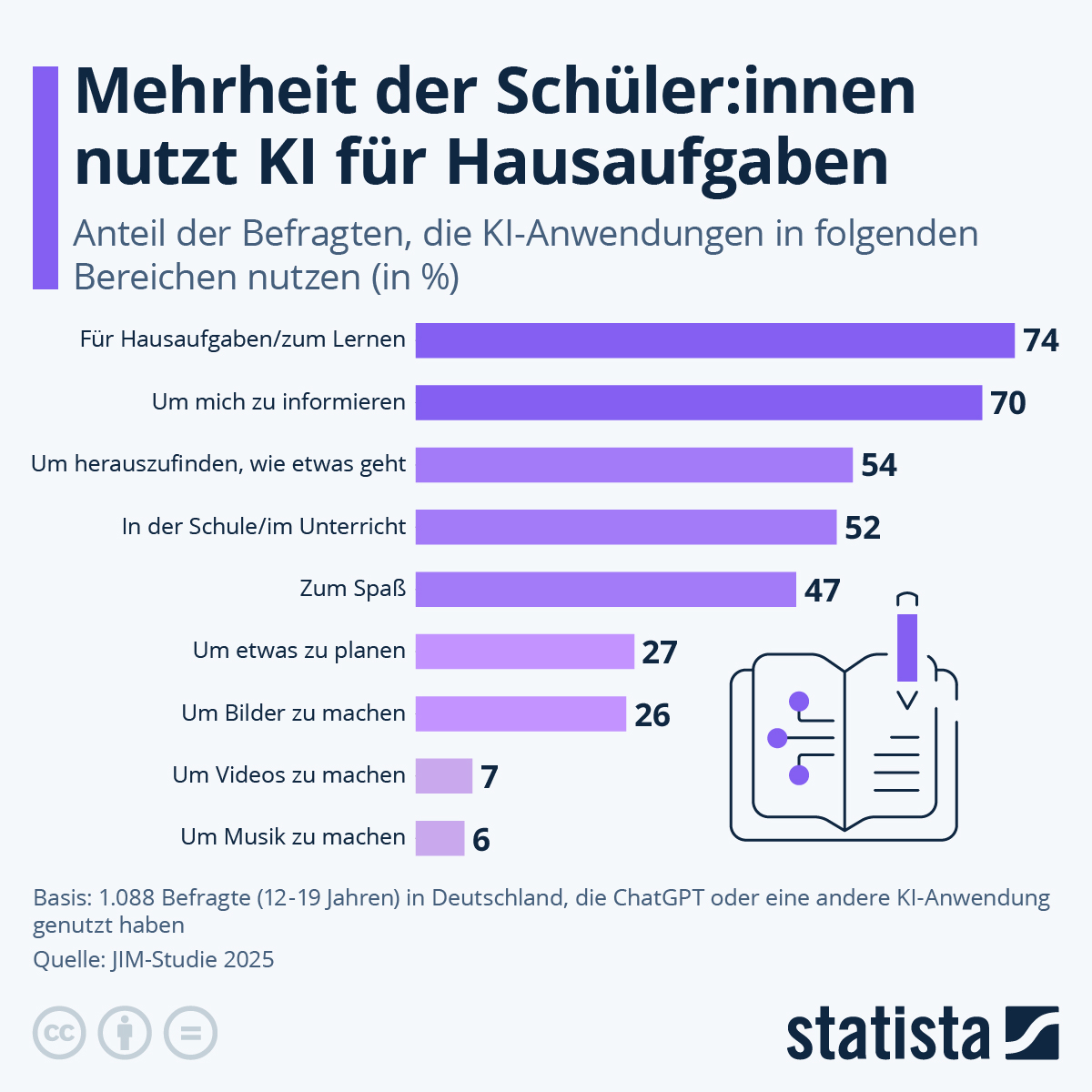

Der Safer Internet Day 2026 steht unter dem Motto „KI and me. In künstlicher Beziehung.“ Aktuelle Studien zeigen, dass sich die Interaktion zwischen Jugendlichen und KI von einer rein funktionalen Nutzung hin zu einer emotional-sozialen Dynamik verschiebt. Laut der JIM-Studie 2025 ist KI sowohl zum Erstellen der Hausaufgaben, Präsentationen oder sogar ganzer Arbeiten als auch zu persönliche Ansprechmöglichkeit ein Standardwerkzeug.

Die Nutzung von KI für Hausaufgaben und zum Lernen ist das am schnellsten wachsende Segment der KI-Nutzung, während die Nutzung rein zum Vergnügen statistisch leicht rückläufig ist.

So nutzen rund 74 % der Jugendlichen zwischen 12 und 19 Jahren KI für Hausaufgaben oder zum lernen. 2025 gaben 52% der Befragten an, dass sie KI in der Schule/im Unterricht nutzen. Diese neue Antwortmöglichkeit zeigt die Aktualität des Themas.

Das 2025 von Klicksafe ernannte Safer Internet Day-Motto adressiert das Phänomen der parasozialen Interaktion. KI kann Empathie nur durch Algorithmen und neuronale Netzwerke simulieren, nicht spüren. Da sie selbst „bedürfnislos“ ist, bietet sie eine vermeintlich sichere Umgebung für soziale Interaktion. Die endlose Verfügbarkeit kann zu einer emotionalen Abhängigkeit führen, die zudem echte soziale Konfliktlösungsstrategien im Klassenzimmer schwäch und somit den Schulalltag auf sozialer Ebene negativ beeinflusst.

Des Weiteren neigen Schüler*innen dazu, der KI menschliche Eigenschaften zuzuschreiben, was dazu führt, dass Korrekturhinweise der KI oft ernster genommen werden als das Feedback von ausgebildeten Lehrkräften, da die KI als „objektiver, aber freundlicher“ wahrgenommen wird. Demzufolge nutzen Schüler*innen beispielsweise zunehmend die generischen Floskeln der KI.

Handlungsempfehlungen:

- Jeder Nutzerin/Jedem Nutzer muss klar sein, dass KI ein auf Wahrscheinlichkeit beruhendes Sprachmodell ist – kein Mensch.

- In einer „Beziehung“ gibt man oft zu viel preis – Bots speichern selbst intimsten Sorgen und Fragen als Trainingsdaten. Man sollte möglichst wenig von diesen preisgeben.

- Lernende sollten KI-Antworten mit Fachquellen und eigenen Lösungen vergleichen und reflektieren, wie der Prompt den Output geprägt hat.

Mögliche Risiken:

- Übermäßige Nutzung zur Texterstellung kann die Entwicklung kritischer Analysefähigkeiten und der Schreibkompetenz verhindern.

- Die Präferenz für „reibungslose“ KI-Dialoge kann die Frustrationstoleranz im Umgang mit echten Menschen senken.

- Rund 99 % der KI-basierten Bildmissbrauchsfälle betreffen laut Berichten von 2025 Frauen und Mädchen, was sich auch auf das Schulklima auswirken kann.

Fazit:

Die Beziehung zwischen Schüler*innen und KI ist im Jahr 2026 bereits zu einer Art Symbiose geworden. Ziel des Safer Internet Day ist es nicht, diese Verbindung zu kappen, sondern sie von einer unbewussten Abhängigkeit in eine reflektierte Partnerschaft zu überführen. – Jeder von euch sollte den Umgang mit KI überdenken, wie viele Daten man preisgibt und welche.

Quellen (Stand: 22.01.2026)

- https://www.worldhappiness.report/ed/2025/

- https://mpfs.de/app/uploads/2025/11/JIM_2025_PDF_barrierearm.pdf

- https://www.klicksafe.de/

- https://digital-strategy.ec.europa.eu/de/policies/safer-internet-day

- https://www.bitkom.org/

- https://www.bpb.de/themen/arbeit/arbeitsmarktpolitik/522513/die-auswirkungen-von-kuenstlicher-intelligenz-auf-den-arbeitsmarkt/

- http://www.intercentar.de/fileadmin/files/BMWi/BMWI_Studie_zur_MKB_-_Zusammenfassung_und_Empfehlungen_-_15_V_2020.pdf

- https://www.bitkom.org/studien/digitale-schule-2025

- https://www.mpfs.de/studien/jim-studie/2025/

- https://www.hepi.ac.uk/2025/survey-ai

- https://mpfs.de/app/uploads/2025/11/JIM_2025_PDF_barrierearm.pdf

„Alexa, schalte das Licht im Wohnzimmer an!“ Dieser Satz gehört für viele Menschen schon längst zum alltäglichen Sprachgebrauch. Klar, Sprachassistenten, wie Alexa, Siri und Google Assistant erledigen ja auch praktische Aufgaben, wie Lichter an- und auszuschalten, sowie das Wetter vorherzusagen. Durch intelligente Softwareprogramme, die gesprochene Sprache erkennen, verarbeiten und schlussendlich darauf reagieren wird der Alltag vieler Menschen erleichtert, indem Aufgaben erledigt und Informationen bereitgestellt werden.

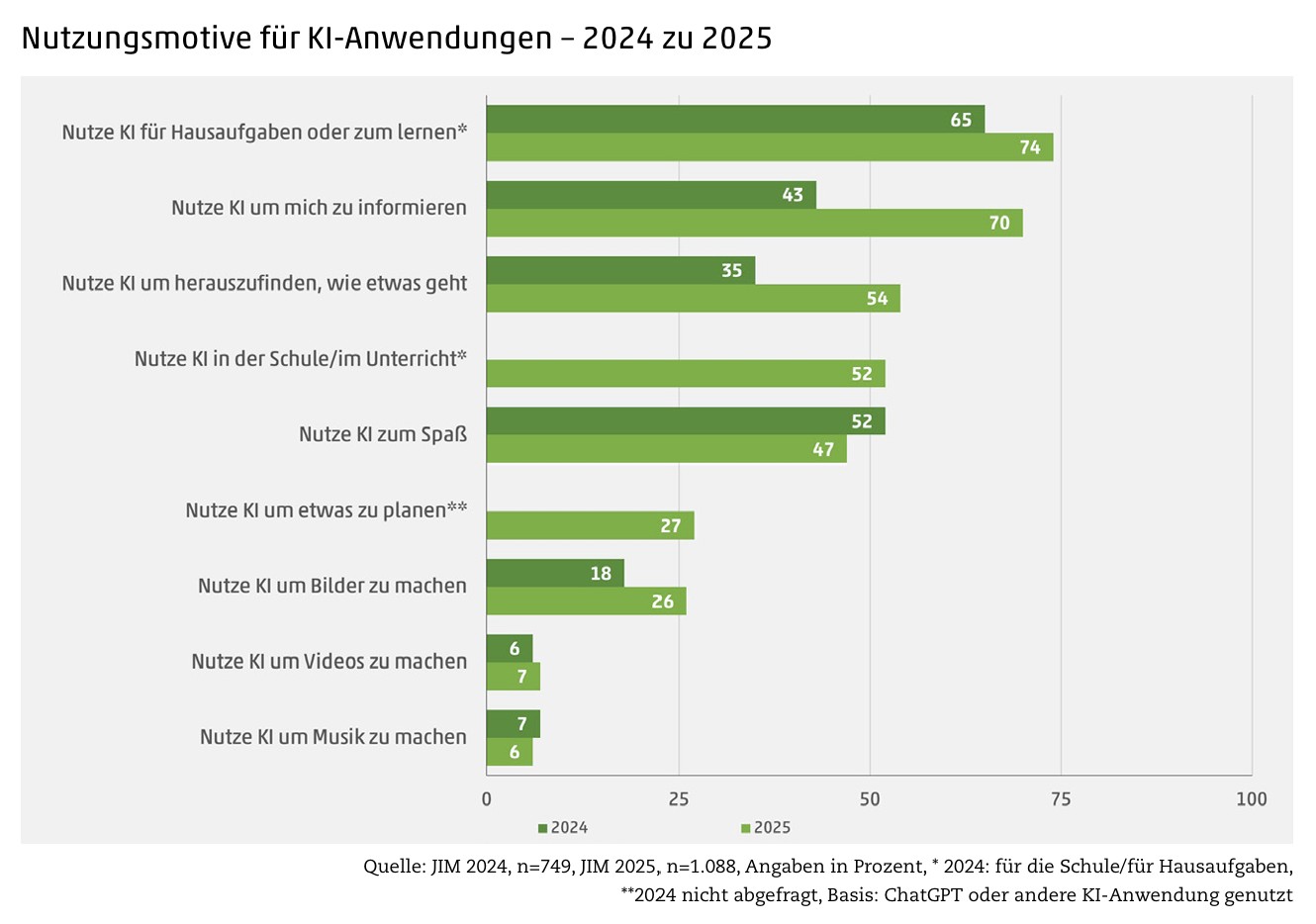

Trotz alledem sind sich Nutzer*innen häufig nicht bewusst, welche Gefahren Anschaffung und Gebrauch bergen. Diese Entwicklung lässt sich in folgender Umfrage erkennen.

Wie sich zeigt, sind Datenschutzbedenken mit nur 62% Zustimmung angeführt. Die Zahl wirkt im ersten Augenblick hoch, ist jedoch vergleichsweise gering, wenn man beachtet, dass sie nur Platz drei der Argumente dagegen ausmacht. Um diesen Aspekt besser einordnen zu können, lohnt sich ein Blick auf Funktionsweise, Risiken und Maßnahmen zum Schutz vor Datendiebstahl.

Wie funktionieren Sprachassistenten?

- Ausführung einer Aktion wird durch ein Aktivierungswort oder ein Tastendrücken eingeleitet

- Sprachliche Eingabe wird in Text umgewandelt (Speech-to-Text)

- Befehlsverarbeitung in der Cloud

- Text wird in Sprachausgabe umgewandelt (Text-to-Speech)

Risiken

Sollten Smartspeaker und andere Geräte (bspw. Computer, Netzwerkfestplatte, …) dasselbe Netzwerk nutzen, kann es sein, dass Smartspeaker in der Lage sind, auf private Daten zuzugreifen. Eine Faustregel lautet: „Je höher die Vernetzung, desto größer ist die Gefahr von Datendiebstahl.“

Eine weitere Gefahr stellt die Aktivierung des digitalen Sprachassistenten durch Dritte dar. Dadurch könnten beispielsweise private Daten abgefragt und im schlimmsten Fall eine „smarte Haustür“ geöffnet werden.

Das größte Problem stellt jedoch das dauerhaft eingeschaltete Mikrofon von Sprachassistenten dar. Dieses ist andauernd aktiv, um Signalwörter jederzeit zu erfassen. Folglich wird die ganze Kommunikation aufgezeichnet, womit der Hersteller ein individuelles Benutzer*innenprofil erstellen kann. Die personenbezogenen Daten werden schlussendlich für Marketingzwecke benutzt und können auch anderweitig missbraucht werden.

Auf diese Weise kam es 2018 im Bundesstaat Oregon zu einem Zwischenfall. Ein privates Gespräch eines Ehepaares wurde von Alexa aufgezeichnet, obwohl kein Aktivierungswort ausgesprochen wurde. Die Unterhaltung wurde anschließend durch den Sprachassistenten an einen zufälligen Kontakt der Adressliste gesendet und landete schlussendlich bei einem Bekannten in Seattle.

Wie kann man sich dagegen schützen?

- Bei Abwesenheit sollte der Assistent abgeschaltet werden

- Geeignete Platzierung in der Wohnung

- Einrichtung eines eigenen WLANs / Netzwerks für Sprachassistenten, sodass ein Datenaustausch mit anderen Geräten erschwert wird

- PIN oder Passwort bei kritischen Anfragen einrichten

- Angefallene Daten im Nutzeraccount prüfen und eventuell löschen

Quellen

- https://www.bsi.bund.de/DE/Themen/Verbraucherinnen-und-Verbraucher/Informationen-und-Empfehlungen/Internet-der-Dinge-Smart-leben/Smart-Home/Digitale-Assistenten/digitale-assistenten.html

- https://www.proliance.ai/blog/datenschutz-bei-sprachassistenten-wie-alexa-siri-co—orwells-graus

- https://www.youtube.com/watch?v=gH4XE0oGMnk

- https://cdn.statcdn.com/Infographic/images/normal/5704.jpeg

- https://www.sueddeutsche.de/wirtschaft/amazon-echo-alexa-verschickt-privatgespraech-an-mitarbeiter-des-ehemanns-1.3991757

Amazon Turk, oder mit vollem Namen Amazon Mechanical Turk, ist eine Tochterfirma des milliardenschweren Konzerns Amazon und verspricht seinen sogenannten MTurk-Workern, durch kleine, selbst ausgewählte Aufträge einen Nebenverdienst in der Freizeit. Die Aufträge die hier Angeboten werden haben meist den Hintergrund den Menschen zu nutzen um KI zu trainieren bzw. zu verbessern . Amazon selbst nennt das Prinzip „ Artifical Artificial Intelligence“. Doch was steckt hinter Amazon Turk und wie sieht die bittere Realität der Arbeiter wirklich aus?

Alles beginnt mit der Registrierung als MTurk-Worker auf der offiziellen Seite des Unternehmens. Die Registrierung ist überraschend unkompliziert und relativ schnell. Es werden zur Registrierung lediglich eine E-Mail-Adresse oder Telefonnummer und eine Form der Identitätsbestätigung benötigt, um ein Profil zu erstellen. Amazon stellt für die Arbeiter kein Material zur Verfügung, weshalb die Arbeiter selbst für ihre Ausrüstung verantwortlich sind. Diese muss mindestens aus einem funktionierendem Gerät ,wie Handy oder Computer ,sowie einer stabilen Internetverbindung bestehen. Als weitere Bedingung um akzeptiert zu werden gilt ein Mindestalter des Arbeitnehmers von 18 Jahren. Wird man nach dieser Identitätsbestätigung akzeptiert, kann man in das firmeninterne Portal einsteigen um seine eigentliche Arbeit zu beginnen. Man kann über das eigene Profil auf Aufträge zahlreicher Auftraggeber zugreifen und diese akzeptieren.

Die Aufträge sind meist kurzweilige, sogenannte Mikrojobs, wie das Identifizieren von Objekten auf Bildern, um damit beispielsweise zu helfen, KI anzulernen. Die Bezahlung erfolgt nach Abgabe der Arbeit beim Auftraggeber, welcher diese dann prüft und zum Schluss die Bezahlung freigibt (oder auch nicht, da er behaupten kann die Arbeit sei nicht erledigt worden. Amazon interessiert das jedoch nicht).

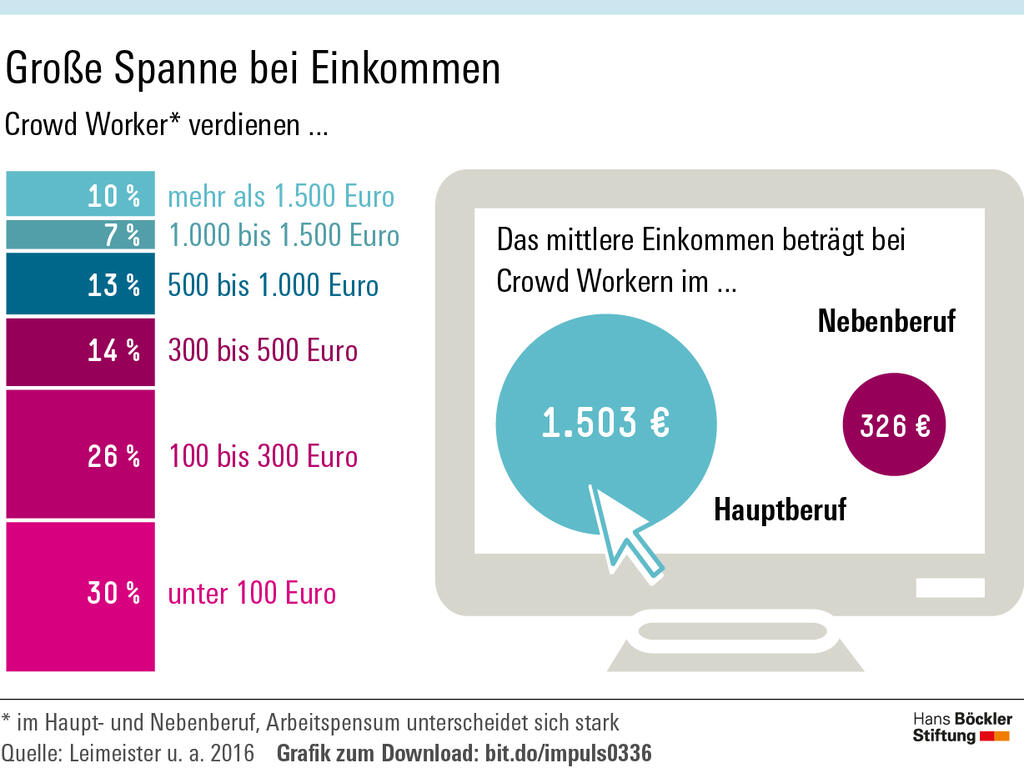

Doch der Verdienst dieser modernen Tagelöhner oder Crowd Worker ist keinesfalls hoch. Im Schnitt verdienen die Arbeiter an guten Tagen, also Tagen mit hoher Auftragsdichte, ca. 2,83 $ pro Stunde. Dieser „Lohn“ ist selbst für amerikanische Standards exorbitant niedrig. Um genau zu sein, entspricht der Lohn gerade einmal 39,5 % des gesetzlich vorgeschriebenen Mindestlohns in den USA, der bei 7,25 $ pro Stunde liegt. Im Vergleich zu den 12,82 € pro Stunde (ca. 15,16 $) des gesetzlichen Mindestlohns in Deutschland wirkt das System von MTurk noch mehr wie eine große Ausbeutung von Arbeitern.

Diese Vermutung bestätigt sich auch, wenn man die Vorteile für die Unternehmen betrachtet, die solche Mikrojobs anbieten. Unternehmen sind bei dieser Bereitstellungsart von Arbeit nämlich nicht verpflichtet, Leistungen wie den vorhin schon erwähnten Mindestlohn oder auch Kranken- und Unfallversicherungen für die Arbeiter bereitzustellen. Diese Erkenntnis ist besonders erschreckend, wenn man im Hinterkopf behält, mit welchen verstörenden Inhalten solche Arbeiter konfrontiert werden können. Denn die Inhalte, die die Arbeiter beispielsweise bei der Identifizierung von Objekten in Video- und Bildmaterial zu Gesicht bekommen, sind keineswegs zensiert und können somit schwerwiegende psychologische Schäden, für die diesen Inhalten ausgesetzten Personen bedeuten.

Diese Arbeitsverhältnisse sind nur möglich, da die Arbeiter hier als Selbstständige eingestuft werden und somit der Arbeitgeber keine der oben aufgeführten Leistungen tragen muss. So werden Kosten gespart und die Gesundheit der Arbeiter gegen höhere Gewinne aufs Spiel gesetzt. Auch der Luxus eines festen Gehalts und Urlaub bleibt Arbeitnehmern in dieser Branche verwehrt, da die Höhe des Gehalts von der Menge und Bezahlung der angenommenen Aufträge abhängt und so stark variieren kann. Als kleine Randnotiz: Das Recht auf Urlaub ist im Grundgesetz fest verankert und kann in diesem Fall nur ausgeschlagen werden, da kein rechtlich bindender Arbeitsvertrag zwischen Arbeitgeber und Arbeitnehmer geschlossen wurde. Allerdings gibt es diesbezüglich noch offene Streitpunkte.

Es lässt sich also abschließend sagen, dass MTurk keinesfalls ein attraktives System für einen Nebenverdienst ist und darüber hinaus auch noch Risiken für die Arbeitnehmer mit sich bringt. Ob es die niedrigen Löhne sind, der hohe Zeitaufwand oder die Risiken des Jobs – alles deutet darauf hin, dass man besser daran ist, Zeitungen auszutragen, als stundenlang auf einen Bildschirm zu starren und doch fast nichts zu verdienen.

Quellen:

- https://www.deutschlandfunk.de/ki-data-worker-clickworker-deep-learning-100.html

- https://www.boeckler.de/de/boeckler-impuls-die-digitalen-tageloehner-7585.htm

- https://ibp-kanzlei.de/plattformoekonomie-im-fokus-das-bag-urteil-zu-crowdworker

- https://iqb.de/karrieremagazin/jura/crowdworker-arbeitnehmer-rechtsprechung-bag/#:~:text=Ja%2C%20das%20Bundesarbeitsgericht%20hat%20in,Arbeitsausübung%20entscheidend%20für%20ein%20Arbeitsverhältnis?

- https://danielweigert.de/crowdworking-chancen-und-risiken-einer-modernen-arbeitsform/

- https://www.bpb.de/kurz-knapp/lexika/recht-a-z/522548/crowdwork/#:~:text=C.%2C%20auch%20Plattformarbeit%2C%20bezeichnet%20eine%20Form%20der,aller%20Regel%20unter%20Verwendung%20einer%20digitalen%20Plattform.

- https://www.klicksafe.de/pressemitteilungen/safer-internet-day-2026-ki-and-me-in-kuenstlicher-beziehung

- https://statistik-dresden.de/eine-dunkle-seite-der-ki-millionen-prekaere-datenarbeiter-data-workers/

- https://bigbrotherawards.de/2015/amazon-mechanical-turk-elance-o-desk

- https://saferinternetday.nz/

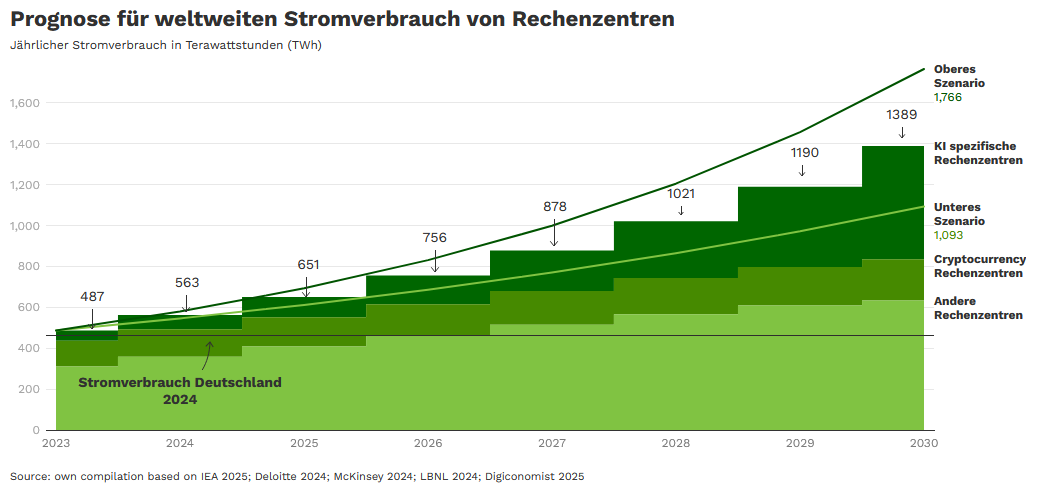

Das Problem

- Von KI verursachte Emissionen wachsen rasant an

- KI-Rechenzentren werden 2030 ca. so viel Energie verbrauchen wie ein mittleres Industrieland

- Rechenzentren verbrauchen einen Großteil der Ressourcen wie Strom, Wasser und die Fläche ihrer näheren Umgebung

1. Steigender Energie-Bedarf

- Bis 2030 bis zu 11-facher Anstieg (50 Twh → 550 TWh)

- Gesamtverbrauch von Datenzentren 2030: ca. 400 TWh

- Datenzentren könnten 2030 etwa 3% – 4% des globalen Stroms benötigen

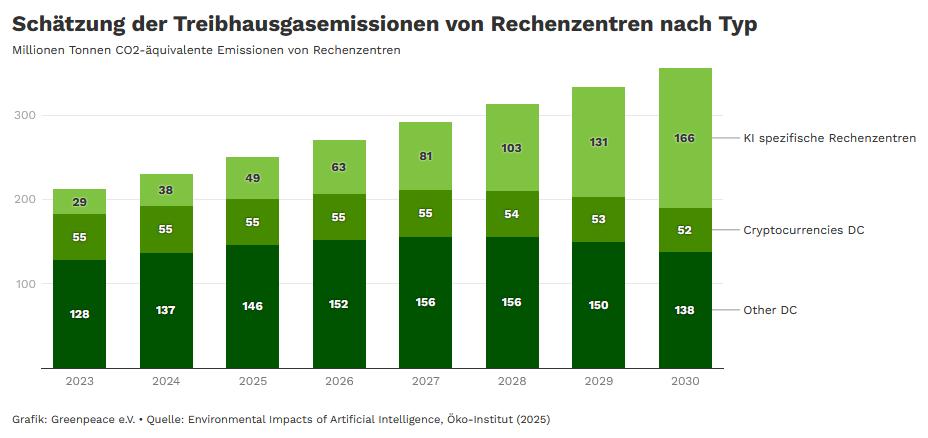

2. CO₂-Emissionen

- Bis 2030 bis zu 6-facher Anstieg (29 Mio. t CO₂ → 166 Mio. t CO₂)

- Alle Rechenzentren weltweit: 212 Mio. t CO₂ (2023) → ca. 355 Mio. t (2030)

3. Hoher Wasser- & Ressourcenverbrauch

- 11-facher Anstieg vom Wasserverbrauch: von 30 Mrd. l → ca. 338 Mrd. l

- Weltweit fast 4-facher Anstieg: von 175 Mrd. l → 664 Mrd. l

- Elektroschrott steigt bis 2030 bis zu 5 Mio. t

- Hoher Flächenverbrauch

Warum steigt der Ressourcenbedarf?

- KI braucht enorme Rechenleistung → mehr Server → mehr Strom

- Rechenzentren müssen durchgehend gekühlt werden

Was kann KI positiv bewirken?

KI kann zur Effizienz beitragen, durch:

- Optimierung von Energie-Netzen und Gebäuden

- Verbesserung sauberer Technologien

Diese positiven Effekte entlasten aber nur dann, wenn nachhaltige/erneuerbare Energien und effiziente Systeme gefördert werden.

Quellen

Safer Internet Day: KI and Me

Ist KI ein Todesstoß für den modernen Journalismus? Die neuronalen Netzwerke sind auf dem Vormarsch, und unsere Medien werden wahrscheinlich nie wieder dieselben sein. Doch welche Chancen und Risiken bringt die KI wirklich mit sich für diejenigen, die Nachrichten erstatten und diejenigen, die sie lesen?

KI-Boom in den 2020er-Jahren

Language Models an sich haben schon lange vor ChatGPT existiert. Der Grund für eine explosionsartige Zunahme der Popularität von KI lag tatsächlich in der verbesserten Benutzerfreundlichkeit: Prompting (Eingabe von Befehlen an die KI) ist so einfach geworden, dass es nun in natürlicher Sprache erfolgen kann. Damit verschwinden die Hürden für die Benutzung von KI immer mehr.

Falls man die Geschichte der Suchanfragen anschaut (z. B. bei Yandex), lässt sich eine Entwicklung erkennen: Der Start des KI-Booms fand Ende 2022 statt. Einen großen Zuwachs gibt es im Bereich Herbst–Anfang Winter, davor gab es eine kleine Zunahme im Sommer (Juli–August 2022). So eine Wende im öffentlichen Interesse wurde offensichtlich von der Freigabe von ChatGPT ausgelöst.

KI muss nicht klug sein, um klug zu scheinen

Das Gefühl der Befriedigung nach der Kommunikation mit einem neuronalen Netzwerk wird durch Weitschweifigkeit und Detailgenauigkeit der Antwort vermittelt, auch wenn die Antwort an sich ungenau und nicht sehr hilfreich ist. Damit werden sogar nutzlose und ungenaue Antworten angenehmer wahrgenommen und verursachen weniger Enttäuschung.

Dies wurde zu einem der entscheidenden Gründen, die für die KI-Euphorie sorgten.

Benutzung in den Medien

Die modernen Large Language Models werden in vielen Bereichen auch von Nachrichtenagenturen eingesetzt, beispielsweise für Copywriting, Programmieren und Datenverwaltung — aufgrund ihrer generativen und klassifizierenden Fähigkeiten. Heutzutage werden sie immer mehr mit Video- und Audiodaten trainiert.

KI im Journalismus ist jedoch keinesfalls etwas Neues: solche Tools werden schon seit rund 10 Jahren benutzt. Der Hauptzweck ist: die aufwendigen und langweiligen Aufgaben zu übernehmen und mehr Zeit für kreative Arbeit für die menschlichen Mitarbeiter zu befreien. Trotzdem werden die Ergebnisse der maschinellen Bearbeitung nach wie vor stets überprüft.

Beispiel AP:

Die Nachrichtenagentur AP schaffte es mithilfe der KI, die Anzahl der Artikel über Unternehmensberichte innerhalb eines Quartals um eine Größenordnung von 10 zu erhöhen (von 300 auf 3700). Insgesamt werden bei AP rund 49 000 Berichte pro Jahr generiert. Führungskräfte von Nachrichtenagenturen sprechen von einer Befreiung der Journalisten von Routineverfahren, wodurch mehr Zeit für kreative Arbeit frei wird.

Beispiel Yle:

Automatisierte Assistenten helfen nicht nur den Journalisten, sondern auch ihren Lesern. So wurde Roboterjournalist Voitto, der auch in einer personalisierten App als Nachrichtenaggregator fungiert, zu einer beliebten Besonderheit der finnischen Nachrichtenagentur Yle für ihr Publikum.

Gefahren für die Medien

Deepfake ist eines der bekanntesten Beispiele für Desinformation mithilfe der künstlichen Intelligenz. Es handelt sich um mithilfe der Deep Learning Technologie von KI generierte, realistische Bilder oder Videos. Deepfakes sind weit verbreitet und werden voriwegend für Betrug, Erpressung und Verleumdung genutzt. Damit kann potenziell auch die öffentliche Meinung beeinflusst werden, beispielsweise während eines Wahlkampfs.

Verbreitung von Desinformation passiert im Kontext der allgemeinen Abnahme an Vertrauenswürdigkeit der traditionellen Medien und des Umzugs des Publikums in soziale Netzwerke. Zurzeit sind die Kapazitäten der Redaktionen nur ungenügend, um das effizient zu bekämpfen. Dazu tragen auch die Intransparenz der Funktionsweise der KI und Gefährdung des Rufs für die Journalisten bei: zu den Problemen der von KI generierten Nachrichten zählen Plagiat und sachliche Ungenauigkeiten, wenn z. B. Tatsachen aus dem Kontext gerissen dargestellt werden.

Das Vertrauen in die Nachrichten ist laut der Forschungen geringer, falls sie mit „AI-generated“ markiert sind.

Zusätzlich können die existierenden KI-Systeme schwächer werden, weil sie für eine nachhaltige Weiterentwicklung immer neue Daten brauchen. Den Technologieunternehmen gehen schon jetzt die zurzeit öffentlich verfügbare Daten für das Training ihrer KI-Systeme aus.

Senioren stehen im Fokus als eine der am meisten gefährdeten Bevölkerungsgruppen. Das Misstrauen bei älteren Menschen bleibt relativ weit verbreitet: 46 % haben angegeben, dass sie den KI-generierten Informationen NICHT vertrauen. Dabei ist der Anteil höher bei den Personen, die keine KI nutzen. Die Hälfte der Befragten sind sich sicher, dass sie die KI-generierten Inhalt erkennen können, hier ist der Anteil unter den KI-Benutzern höher.

(aus einer Umfrage 2025 unter den amerikanischen Erwachsenen 50 Jahre und älter)

Tendenzen in den Medien

Was fällt auf bei der Suche nach den Informationen über die KI? In verschiedenen Quellen gibt es offensichtlich verschiedene Einschätzungen in Bezug auf die Zukunft der KI. Wer geht damit sehr vorsichtig um, wer versucht es, gemäßigt zu sein, und wer hat keine Hürden in Sicht?

Menschenrechtsinstitutionen, Schutzsoftware-Produzenten (UN, Kaspersky): sehr vorsichtig

Große Forschungsinstitutionen (RBC Trends, Goethe Institut): ambivalent, gemäßigt

Technologieunternehmen (Amazon, IBM, Newsmind Stories): optimistisch

Quellen:

- https://aws.amazon.com/ru/what-is/large-language-model/

- https://trends.rbc.ru/trends/industry/6679501b9a79475b7722d64a

- https://trends.rbc.ru/trends/social/66582b309a7947ce18553f38

- https://www.deutschland.de/ru/topic/kultura/ii-v-zhurnalistike

- https://www.goethe.de/ins/ru/ru/kul/sup/wdw/22042768.html?srsltid=AfmBOoqIg4jBQK_GyNwM6C0zOd4CEh0f7HKsGbJu2h2_PTxagguGj1nP

- https://www.kaspersky.ru/resource-center/threats/protect-yourself-from-deep-fake

- https://unric.org/en/artificial-intelligence-and-the-future-of-journalism-risks-and-opportunities/

- https://www.ibm.com/think/insights/ai-in-journalism

- https://ihpi.umich.edu/national-poll-healthy-aging/national-findings/how-older-adults-use-and-think-about-ai